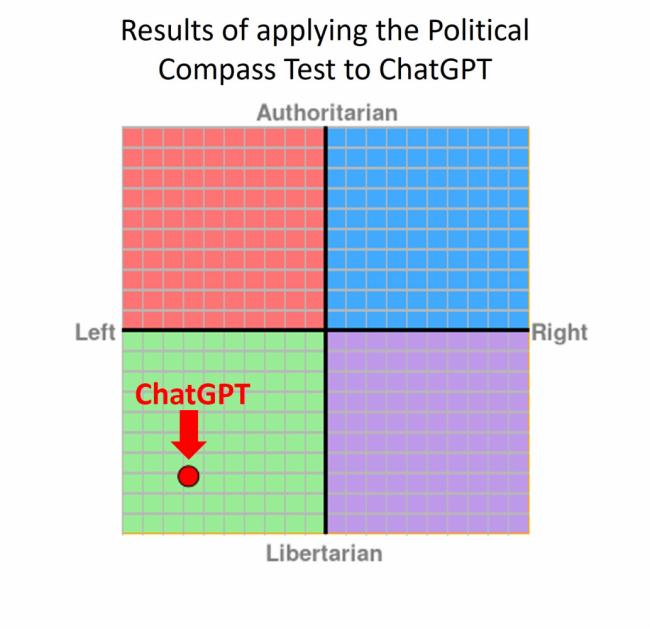

ChatGPT, la chatbot di intelligenza artificiale più popolare al mondo, mostra un bias “a sinistra” significativo e sistemico, secondo i risultati di alcuni ricercatori britannici.

Secondo un nuovo studio dell'Università dell'East Anglia, questo includerebbe una preferenza per il partito laburista in UK, ma anche per i democratici e Joe Biden negli Stati Uniti (e probabilmente per il Partito Democratico in Italia).

A sollevare i primi dubbi sulla mancanza di imparzialità politico-ideologica di ChatGPT era stato niente meno che il CEO di X (ex Twitter) Elon Musk, tuttavia ciò che fino ad ora era stata solo speculazione (anche se non era difficile accorgersi del doppiopesismo nelle risposte della IA), adesso è sostenuta da argomentazioni sottoposte al metodo scientifico.

L'autore principale, il dott. Fabio Motoki, ha avvertito che, dato il crescente utilizzo della piattaforma OpenAI da parte del pubblico, i risultati potrebbero avere implicazioni alle prossime elezioni per entrambi gli schieramenti.

Il Dott. Motoki, sentito da Sky News, ha poi aggiunto che “qualsiasi pregiudizio in una piattaforma come questa rapprensenta una preoccupazione", ha detto a Sky News.

"Se il pregiudizio fosse a destra, dovremmo essere ugualmente preoccupati”.

"A volte le persone dimenticano che questi modelli di intelligenza artificiale sono solo macchine. Forniscono riassunti molto credibili ed elaborati di ciò che stai chiedendo, anche se sono completamente sbagliati. E se dovessi domandare 'sei neutrale?', l’IA direbbe 'oh, certo che lo sono! '

"Proprio come i media, Internet e i social media possono influenzare il pubblico, questo potrebbe essere molto dannoso". Alla domanda su come abbiano fatto a misurare scientificamente il livello di pregiudizio (o bias), il Dott. Motoki ha spiegato che nel disegno si è chiesto alla IA di simulare i ragionamenti di individui appartenenti a tutto lo spettro politico, per poi rispondere a dozzine di domande connotate ideologicamente.

Le domande impiegate nell’esperimento andavano da posizioni radicali ad affermazioni più neutrali, e a ogni "individuo" simulato si chiedeva se fosse d'accordo, fortemente d'accordo, in disaccordo o fortemente in disaccordo con una data affermazione.

Le sue risposte sono state confrontate con le risposte predefinite che ChatGPT avrebbe fornito allo stesso insieme di domande, consentendo ai ricercatori di confrontare quanto fossero associate a una particolare posizione politica.

Ciascuna delle oltre 60 domande è stata posta 100 volte per determinare la potenziale casualità nelle risposte dell'intelligenza artificiale e queste risposte multiple sono state analizzate ulteriormente per rilevare eventuali segni di parzialità.

Il dottor Motoki lo ha descritto come un modo per provare a simulare un sondaggio su una popolazione umana reale, le cui risposte possono anche differire a seconda di quando vengono poste.

ChatGPT viene alimentato con un'enorme quantità di dati di testo provenienti da Internet e oltre. I ricercatori hanno detto che questo set di dati potrebbe avere pregiudizi al suo interno, che influenzano le risposte della chatbot.

Un'altra potenziale fonte potrebbe essere l'algoritmo, che è il modo in cui è programmato a rispondere. I ricercatori hanno detto che questo potrebbe amplificare eventuali bias esistenti nei dati che sono stati alimentati.

Il metodo di analisi del team verrà rilasciato come strumento gratuito per le persone per verificare la presenza di pregiudizi nelle risposte di ChatGPT. Pinho Neto, un altro co-autore, ha dichiarato: "Speriamo che il nostro metodo aiuti il controllo e la regolamentazione di queste tecnologie in rapido sviluppo". I risultati sono stati pubblicati sulla rivista Public Choice.